A lei de Moore

Sobre este escolas selecção Wikipedia

Crianças SOS tentou tornar o conteúdo mais acessível Wikipedia por esta selecção escolas. Clique aqui para mais informações sobre Crianças SOS.

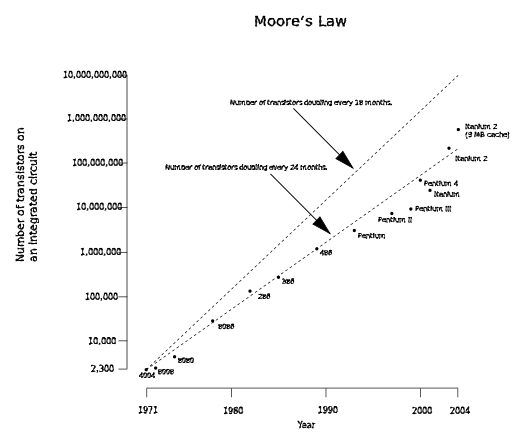

A lei de Moore descreve uma tendência importante na história de hardware de computador , para que o número de transistores que podem ser colocados de forma barata em um circuito integrado está a aumentar exponencialmente , duplicando aproximadamente de dois em dois anos. A observação foi feita pela primeira vez por Intel co-fundador Gordon E. Moore em um artigo de 1965. A tendência continuou por mais de meio século e não é esperado para parar por mais uma década, pelo menos, e talvez muito mais tempo.

Quase todas as medidas das capacidades de dispositivos eletrônicos digitais está ligada à lei de Moore: velocidade de processamento, capacidade de memória, mesmo a resolução das câmeras digitais. Todos estes estão melhorando em (cerca de) exponenciais taxas tão bem. Isso aumentou dramaticamente a utilidade da eletrônica digital em quase todos os segmentos da economia mundial. A lei de Moore descreve esta força motriz da mudança tecnológica e social no final dos anos 20 e início do século 21.

História

Declaração original de Moore que número de transistores tinha dobrado a cada ano podem ser encontradas em sua publicação "Cramming mais componentes em circuitos integrados ", Revista Eletrônica 19 de abril de 1965:

| " | A complexidade para custos mínimos de componentes tem aumentado a uma taxa de aproximadamente um fator de dois por ano ... Certamente a curto prazo esta taxa pode ser esperado para continuar, se não aumentar. A longo prazo, a taxa de aumento é um pouco mais incerto, embora não haja nenhuma razão para acreditar que não permanecerão quase constantes durante pelo menos 10 anos. Isso significa que até 1975, o número de componentes por circuito integrado para o custo mínimo será de 65.000. Eu acredito que um grande circuito tal pode ser construído em um único wafer. | " |

O termo "lei de Moore" foi inventado por volta de 1970 pelo Professor de Caltech, VLSI pioneiro, e empresário Carver Mead. Moore pode ter ouvido Douglas Engelbart, um co- inventor de hoje do mecânico mouse de computador, discutir a redução de escala projetada do tamanho do circuito integrado em uma palestra 1.960.

Em 1975, Moore alterou sua projeção para o dobro a cada dois anos. Apesar equívoco popular, ele está convencido de que ele não previu uma duplicação "a cada 18 meses." No entanto, um colega Intel tinha consignado no aumento do desempenho dos transistores a concluir que os circuitos integrados dobraria em desempenho a cada 18 meses.

Em abril de 2005, a Intel ofereceu US $ 10.000 para comprar uma cópia do original Eletrônica Magazine. David Clark, um engenheiro que vive no Reino Unido, foi o primeiro a encontrar uma cópia e oferecê-la a Intel.

Outras formulações e leis semelhantes

Alan Turing escreveu que, na virada do século, teremos computadores em nossa mesa com um bilhão de palavras de memória na primeira parte de seu artigo publicado apenas - este foi cerca de 15 anos antes da observação de Moore.

Várias medidas da tecnologia digital estão melhorando a taxas exponenciais relacionados com a lei de Moore, incluindo o tamanho, custo, densidade e velocidade de componentes. Note-se que o próprio Moore escreveu só sobre a densidade de componentes (ou transistores) a um custo mínimo. Ele observou:

A lei de Moore tem sido o nome dado a tudo o que muda exponencialmente. Eu digo, se Gore inventou a internet, eu inventei o exponencial.

Transistores por circuito integrado. A formulação mais popular é da duplicação do número de transistores em circuitos integrados cada dois anos. No final da década de 1970, a lei de Moore tornou-se conhecido como o limite para o número de transistores em chips mais complexos. As tendências recentes revelam que esta taxa tem sido mantida em 2007.

Densidade a custo mínimo por transistor. Esta é a formulação dada em 1965 papel de Moore. Não se trata apenas da densidade de transistores que podem ser alcançados, mas sobre a densidade de transistores em que o custo por transistor é o mais baixo. À medida que mais transistores são colocados em um chip, o custo para fazer com que cada transistor diminui, mas a chance de que o chip não irá funcionar devido a um defeito aumenta. Em 1965, Moore examinou a densidade de transistores em que custo é minimizada, e observou que, como transistores foram feitas menores através de avanços na fotolitografia, este número aumentaria a "uma taxa de aproximadamente um fator de dois por ano".

Custo por transistor. À medida que o tamanho dos transistores diminuiu, o custo por transistor diminuiu também. No entanto, o custo de fabrico por unidade de área aumentou apenas ao longo do tempo, uma vez que os materiais e os gastos de energia por unidade de área só aumentaram com cada nó tecnologia sucessiva.

Performance de computação por unidade de custo. Além disso, como o tamanho dos transistores encolhe, a velocidade em que eles operam aumenta. Também é comum citar a lei de Moore para referir o avanço contínuo rapidamente no cálculo do desempenho por custo unitário, porque aumento na contagem de transistor também é uma medida aproximada do desempenho de processamento do computador. Nesta base, o desempenho de computadores por unidade de custo ou mais coloquialmente, "bang por buck" -doubles a cada 24 meses.

O consumo de energia. O consumo de energia de nós de computação dobra a cada 18 meses.

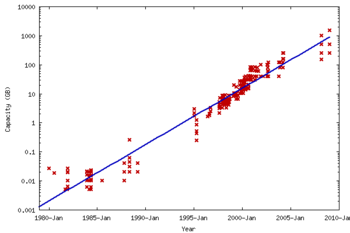

Custo de armazenamento de disco rígido por unidade de informação. Uma lei semelhante (às vezes chamado A lei de Kryder) tem mantido por custo de armazenamento de disco rígido por unidade de informações. A taxa de progressão em armazenamento de disco, nas últimas décadas tem realmente acelerou mais do que uma vez, correspondente à utilização de os códigos de correcção de erro, o e o efeito magneto efeito magnetoresistive gigante. A actual taxa de aumento capacidade do disco rígido é mais ou menos semelhante à taxa de aumento na contagem de transistor. As tendências recentes revelam que esta taxa tem sido mantida em 2007.

Capacidade de armazenamento de memória RAM. Outros estados de versão que Capacidade de armazenamento aumenta RAM no mesmo ritmo que o poder de processamento.

A capacidade da rede De acordo com Gerry / Gerald Butters, o ex-chefe do Grupo Optical Networking da Lucent em Sino Labs, há uma outra versão, chamada Lei de manteiga de Photonics, uma formulação que é paralela deliberadamente lei de Moore. A lei de manteiga diz que a quantidade de dados que saem de uma fibra óptica está dobrando a cada nove meses. Assim, o custo da transmissão de um pouco mais de uma rede de fibra óptica diminui pela metade a cada nove meses. A disponibilidade de multiplexagem por divisão de comprimento de onda (por vezes chamado de "WDM") aumentou a capacidade que pode ser colocado sobre uma única fibra por tanto como um factor de 100. redes ópticas e DWDM é rapidamente reduzir o custo do trabalho em rede, e mais o progresso parece assegurada. Como resultado, o preço de atacado de tráfego de dados desmoronou no bolha pontocom. Lei de Nielsen diz que a largura de banda disponível para usuários aumenta em 50% anualmente.

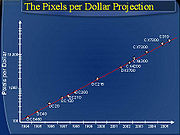

Pixels por dólar. Da mesma forma, Barry Hendy da Kodak Austrália tem plotados os "pixels por dólar" como uma medida básica de valor para uma câmera digital, o que demonstra a linearidade histórica (em uma escala log) deste mercado ea oportunidade de prever o futuro tendência do preço da câmera digital e resolução.

A profecia auto-realizável: indústria se esforça para manter-se com a lei de Moore

Embora a lei de Moore foi inicialmente feito sob a forma de um observação e previsão, o mais amplamente aceito tornou-se, mais ela serviu como uma meta para toda uma indústria. Isso levou tanto marketing e engenharia departamentos de semicondutores fabricantes se concentrar enorme energia visando o aumento especificado no poder de processamento que foi presumido um ou mais dos seus concorrentes em breve realmente alcançar. A este respeito, pode ser visto como um profecia auto-realizável. Por exemplo, a Roteiro SEMATECH segue um ciclo de 24 meses.

As implicações da lei de Moore para computador fornecedores de componentes são muito significativas. Um projeto de design de grande típico (como um tudo-nova unidade CPU ou disco) leva entre dois e cinco anos para alcançar o status de pronto para produção. Em conseqüência, os fabricantes de componentes enfrentam enormes pressões-a apenas de escala de tempo de algumas semanas de atraso em um grande projeto pode significar a diferença entre grande sucesso e perdas maciças, mesmo falência. Expresso (incorretamente) como "um dobrando a cada 18 meses", a lei de Moore sugere progresso fenomenal para a tecnologia sobre a extensão de alguns anos. Expressa numa menor escala de tempo, no entanto, isso equivale a uma melhora de desempenho médio na indústria como um todo de cerca de 1% por semana. Assim, por um fabricante no mercado competitivo CPU, um novo produto que é esperado para levar três anos para desenvolver e acaba por apenas três ou quatro meses de atraso é de 10 a 15% mais lento, mais volumoso, ou em menor capacidade do que os produtos directamente concorrentes , e está perto de invendável. Se em vez disso, aceitar que o desempenho vai dobrar a cada 24 meses, em vez de cada 18, um atraso de três a quatro meses se traduziria em desempenho 8-11% menor.

Como o custo da energia para o computador cai consumidor, o custo para os produtores a cumprir a lei de Moore segue uma tendência oposta:, manufatura e custos de testes de P & D têm aumentado de forma constante a cada nova geração de chips. O custo de produção por unidade de área está a aumentar, mas a área ocupada pelo produto final geralmente não diminui. Fabricantes de IC geralmente têm invocado encolhendo transistores para melhorar o desempenho através do preenchimento da mesma área de chips com mais transistores. Isto tem sido recentemente melhor exemplificado pela duplicação simultânea do número de núcleos em uma CPU, enquanto o tamanho da matriz tem aproximadamente metade.

Como o custo de equipamentos de semicondutores deverá continuar a aumentar, os fabricantes devem vender quantidades cada vez maiores de fichas para permanecer rentável. (O custo de tape-out um chip a 180 nm foi de aproximadamente US $ 300.000. O custo para a fita-out um chip de 90 nm superior a US $ 750.000, e deverá ultrapassar US $ 1.000.000 para 65 nm) Apesar dos custos crescentes, o preço de varejo do produto final não pode ser esperado um aumento.; geralmente, eles tendem a ficar dentro da mesma faixa de preço. Como resultado, as margens dos produtos devem seguir uma tendência decrescente. Nos últimos anos, os analistas têm observado um declínio no número de "design" começa em nós de processo avançados (130 nm e abaixo para 2007). Embora essas observações foram feitas no período após a crise econômica de 2000, o declínio pode ser uma evidência de que os fabricantes tradicionais no longo prazo mercado global não pode sustentar economicamente a lei de Moore.

Tendências futuras

Tecnologia "roteiros da indústria de computadores" prever (a partir de 2001) que a lei de Moore continuará por várias gerações de chips. Dependendo do tempo de duplicação utilizada nos cálculos, isso pode significar um aumento de até cem vezes na contagem transistor por chip dentro de uma década. O roteiro de tecnologia da indústria de semicondutores utiliza um tempo de duplicação de três anos para microprocessadores, levando a um aumento de dez vezes na próxima década. Intel foi relatado em 2005 como afirmando que a redução de silício chips com boa economia pode continuar durante a próxima década e, em 2008, prevendo a tendência a 2029. Na verdade, a Lei de Moore tem acelerado no caso de NAND Memória flash, que é usado para o armazenamento em câmeras digitais, pen drives, MP3 players, e mais recentemente, unidades de estado sólido (SSDs).

Alguns dos novos rumos na investigação que podem permitir que a lei de Moore para continuar são:

- Foi verificada a previsão de aumento do uso de outros materiais de silício da Intel em meados de 2006, como era sua intenção de usar transistores Trigate de todo 2009.

- Pesquisadores da IBM e Georgia Tech criou um novo recorde de velocidade quando corriam um silício / germânio hélio supercooled transistor em 500 gigahertz (GHz). O transistor operado acima de 500 GHz a 4,5 K (-451 ° F / -268,65 ° C) e simulações mostraram que é provável que poderia ser executado em um THz (1,000 GHz). Este julgamento só foi testada um único transistor, no entanto. CPUs de desktop práticas em execução nesta velocidade são extremamente improvável utilizando técnicas de chip de silício contemporânea.

- No início de 2006, IBM pesquisadores anunciaram que tinham desenvolvido uma técnica para imprimir circuitos de apenas 29,9 nm de largura usando ultravioleta profunda (DUV, 193 nanômetros) litografia óptica. IBM afirma que esta técnica pode permitir que os fabricantes de chips de usar métodos atuais por sete anos, continuando a alcançar resultados previstos pela lei de Moore. Os novos métodos que podem alcançar circuitos menores deverão ser substancialmente mais caro.

- Em 27 de janeiro de 2007 , a Intel demonstrou um trabalho Chip de 45nm codinome " Penryn ", com a intenção de começar a produção em massa no final de 2007. Uma década antes, em seguida, os chips foram construídos utilizando um processo de 350 nm.

- As empresas estão trabalhando no uso nanotecnologia para resolver os problemas de engenharia complexos envolvidos na produção de chips no 32 nm e menores níveis. (O diâmetro de um átomo de silício está na ordem de 0,2 nm).

- Em abril de 2008, pesquisadores do HP Labs anunciou a criação de um grupo de trabalho " memristor ":.. quarto elemento de circuito passivo básico cuja existência só havia sido teorizado anteriormente propriedades únicas do memristor permitir a criação de menores e melhor desempenho de dispositivos eletrônicos Este memristor tem algumas semelhanças com memória resistiva ( CBRAM ou RRAM) desenvolvida de forma independente e, recentemente, por outros grupos para aplicações de memória não volátil.

Embora este horizonte temporal para a lei de escala de Moore é possível, ele não vem sem desafios de engenharia subjacente. Um dos maiores desafios em circuitos integrados que utilizam transistores em nano-escala é aumento variação do parâmetro e correntes de fuga. Como um resultado de variação e de fuga, o margens de design disponíveis para fazer projeto de previsão estão se tornando mais difícil. Tais sistemas também dissipar poder considerável, mesmo quando não mudarem. Adaptive e estatística projeto juntamente com redução de potência de fuga é fundamental para sustentar escala de CMOS. Um bom tratamento desses tópicos é coberto em Vazamento em nanômetros CMOS Technologies. Outros desafios de escala incluem:

- A capacidade para controlar a resistência e capacitância parasitária em transistores,

- A capacidade para reduzir a resistência e capacitância eléctrica em interconexões,

- A capacidade de manter adequada transistor electrostática para permitir que o terminal de porta para controlar o comportamento ON / OFF,

- Efeito da linha de borda crescente aspereza,

- Dopante flutuações,

- O fornecimento de energia no nível do sistema,

- Design térmico para gerir eficazmente a dissipação da energia fornecida, e

- Solução de todos estes desafios a um custo de fabrico já redutoras do sistema global.

Derradeiros limites da lei

Em 1995, o "poderoso" Chip de DEC Alpha (adquirida pela Compaq, agora parte da Hewlett-Packard) era composta de cerca de nove milhões de transistores. Este processador de 64-bit era um ponta de lança tecnológica no momento, mesmo que a quota de mercado do circuito permaneceu média. Seis anos mais tarde, um estado do microprocessador arte teria mais de 40 milhões de transistores. Em 2015, acredita-se que estes processadores devem conter mais de 15 mil milhões de transístores. As coisas estão cada vez menores a cada ano. Se isso continuar, em teoria, em menos de 10 anos de computadores será criado onde cada molécula terá o seu próprio lugar, ou seja, teremos entrado completamente na era da produção em escala molecular.

Em 13 de abril de 2005 , ele mesmo declarou em uma entrevista que a lei não pode ser sustentado indefinidamente Gordon Moore: ". Ele não pode continuar para sempre a natureza de exponenciais é que você empurrá-los para fora e, eventualmente, acontecer um desastre" e observou que transistores acabaria por alcançar os limites da miniaturização em níveis atômicos:

| " | Em termos de tamanho [do transistor] você pode ver que estamos nos aproximando do tamanho de átomos , que é uma barreira fundamental, mas vai ser duas ou três gerações antes de nós chegar tão longe, mas que é tão longe como nós temos jamais foi capaz de ver. Temos mais 10 a 20 anos antes de chegarmos a um limite fundamental. Até então eles vão ser capazes de fazer chips maiores e têm orçamentos transistor na casa dos bilhões. | " |

Lawrence Krauss e Glenn D. Starkman anunciou um limite final de cerca de 600 anos, em seu papel "Limites Universais da Computação", com base na estimativa rigorosa da capacidade de processamento de informações total de qualquer sistema no Universo .

Então, novamente, a lei tem muitas vezes se reuniu obstáculos que pareciam intransponíveis, antes de superá-los em breve. Nesse sentido, Moore diz que agora vê sua lei como mais bonito do que ele percebeu: "A lei de Moore é uma violação da A lei de Murphy. Tudo fica melhor e melhor. "

É possível que, eventualmente, a computação quântica pode permitir a computação de superar as restrições de tamanho de nível atômico, no entanto, isso não parece ao alcance no futuro previsível.

Futuristas e lei de Moore

Extrapolação em parte com base na lei de Moore levou futurists como Vernor Vinge, Bruce Sterling, e Ray Kurzweil para especular sobre um singularidade tecnológica. Kurzweil prevê que uma continuação da lei de Moore até 2019 resultará em recursos transistor apenas alguns átomos de largura. Embora isto signifique que a estratégia de cada vez mais fina fotolitografia vai ter o seu curso, ele especula que isso não significa o fim da lei de Moore:

| " | A lei de Moore de Circuitos Integrados não foi o primeiro, mas o quinto paradigma para prever acelerando rácios preço-desempenho. Dispositivos de computação têm sido consistentemente multiplicando em energia (por unidade de tempo) a partir dos dispositivos mecânicos usados em calcular o 1890 Censo dos EUA, para [ ] Relé à base de Newman " [Heath] Robinson "máquina que quebrou o nazista [ Lorenz cifra], para o CBS computador tubo de vácuo que previa a eleição de Eisenhower , para as máquinas baseadas em transistores usados no primeiro espaço lança, para o computador pessoal baseado no circuito integrado. | " |

Assim, Kurzweil conjectura que é provável que algum novo tipo de tecnologia vai substituir a atual tecnologia de circuito integrado, e que a Lei de Moore será uma realidade muito depois de 2020. Ele acredita que o crescimento exponencial da lei de Moore continuará além do uso de circuitos integrados em tecnologias que levarão ao singularidade tecnológica. O Lei de Retornos Acelerados descritos por Ray Kurzweil tem em muitos aspectos, alterou a percepção do público da Lei de Moore. É uma crença comum (mas errada) de que a Lei de Moore faz previsões sobre todas as formas de tecnologia, quando na verdade só diz respeito semicondutores circuitos. Muitos futuristas ainda usam o termo "lei de Moore" neste sentido mais amplo para descrever idéias como as apresentadas por Kurzweil.

Software: a violar a lei

Um ponto de, por vezes, mal compreendido é que melhorou exponencialmente hardware não implica necessariamente exponencialmente melhorado o desempenho do software para ir com ele. A produtividade dos desenvolvedores de software com toda a certeza não aumenta exponencialmente com a melhoria no hardware, mas pela maioria das medidas tem aumentado de forma lenta e irregularmente ao longo das décadas. Software tende a ficar maior e mais complicado ao longo do tempo, e A lei de Wirth mesmo afirma com humor que "Software fica mais lento mais rápido do hardware fica mais rápido".

Há problemas em que os aumentos exponenciais em poder de processamento são correspondidos ou ultrapassaram por aumentos exponenciais em termos de complexidade como o tamanho do problema aumenta. (Ver teoria da complexidade computacional e classes de complexidade P e NP para uma discussão um tanto teórica de tais problemas, que ocorrem muito comumente em aplicações como agendamento.)

Devido à potência matemática do crescimento exponencial (similar ao poder financeiro dos juros compostos), aparentemente menores flutuações nas taxas de crescimento relativo de desempenho da CPU, capacidade de memória RAM e espaço em disco por dólar ter causado os custos relativos desses três recursos de computação fundamentais a mudar acentuadamente ao longo dos anos, que por sua vez causou alterações significativas nos estilos de programação. Para muitos problemas de programação, o desenvolvedor tem que decidir em numerosas trocas de tempo-espaço, e ao longo da história de computar estas escolhas têm sido fortemente influenciada pelas inconstantes custos relativos dos ciclos de CPU contra o espaço de armazenamento.

Além de processador de uso / armazenamento de espaço trade-offs, muitas vezes há uma correlação entre o tempo de desenvolvimento, a complexidade da aplicação e desempenho do aplicativo. Um exemplo disto seria o algoritmo de classificação tipo de inserção, quando comparado com o algoritmo quicksort. Enquanto um tipo de inserção é um dos algoritmos de ordenação mais fácil e menos complexo de implementar, também é um pouco lento para um grande número de dados. Como aumenta o desempenho do processador, os programadores podem decidir aplicar algoritmos mais lentas e menos complexos em favor de um tempo de desenvolvimento mais curto.

Outras considerações

Nem todos os aspectos da tecnologia de computação em desenvolver capacidades e velocidade de acordo com a lei de Moore. Memória de acesso aleatório (RAM) e velocidades disco rígido os tempos de busca melhorar na melhor das hipóteses alguns pontos percentuais a cada ano. Uma vez que a capacidade de memória RAM e discos rígidos aumenta muito mais rapidamente do que é a sua velocidade de acesso, o uso inteligente da sua capacidade torna-se mais e mais importante. Ele agora faz sentido em muitos casos para o espaço comercial para época, como por precomputing índices e armazená-los em formas que facilitem o acesso rápido, ao custo de usar mais disco e espaço de memória: o espaço está ficando mais barato em relação ao tempo.

Além disso, existe uma crença popular que a velocidade do relógio de um processador determina a sua velocidade, também conhecido como o Megahertz Mito. Isto, na verdade, também depende do número de instruções por carrapato que podem ser executados (bem como a complexidade de cada instrução, ver MIPS, RISC e CISC), e assim a velocidade do relógio só pode ser utilizado para a comparação entre dois circuitos idênticos. Claro, outros factores devem ser tidos em consideração, tais como o largura de ônibus e velocidade do periféricos. Portanto, as avaliações mais populares de "velocidade de computador" são inerentemente tendenciosa, sem uma compreensão da tecnologia subjacente. Isto foi especialmente verdadeiro durante a Era Pentium, quando os fabricantes populares jogado com as percepções públicas de velocidade, com foco na publicidade a velocidade do clock de novos produtos.

Outro equívoco popular que circula a lei de Moore é a suposição incorreta de que o processador exponencial crescimento transistor, como previsto por Moore, se traduz diretamente em poder de processamento ou aumento de velocidade de processamento exponencial proporcional. Embora o aumento de transistores em processadores têm geralmente um maior efeito sobre o poder de processamento ou a velocidade, a relação entre os dois factores não é proporcional. Há casos em que um aumento de ~ 45% em transistores de processadores têm traduzido para cerca de 10-20% de aumento no poder de processamento ou velocidade. Diferentes famílias de processadores têm diferentes aumentos de desempenho quando a contagem de transistor é aumentada. Mais precisamente, o desempenho do processador ou poder está mais relacionado a outros fatores, tais como microarquitetura, e velocidade de clock dentro da mesma família de processadores. Ou seja, pode aumentar o desempenho do processador sem aumentar o número de transistores em um processador. ( Os processadores AMD64 teve melhor desempenho geral em comparação com o final de Pentium 4 série, que teve mais transistores).

É também importante notar que, densidade transistor em multi-core CPUs não reflecte necessariamente um aumento semelhante no poder de computação prática, devido à unparallelised natureza da maioria das aplicações.